Simulierte Fehler

Deep Learning für die industrielle Computertomographie

Die künstliche Intelligenz ist derzeit in aller Munde. Inwiefern sich ihre Methoden auch in der industriellen Computertomographie (CT) einsetzen lassen, ist derzeit Gegenstand eines Entwicklungsprojekts bei Volume Graphics. Der Hersteller von CT-Analysesoftware lässt sich dabei weit über die Schulter schauen.

Bild 1 | Drei Beispiele simulierter Defekte in Aluminiumgussbauteilen als Polygonnetze und CT-Grauwertbiler: Gasporen (l.) sind eher rund, Lunker (m.) eher zackig mit vielen Ecken, andere Hohlräume (r.) oft flach und gekrümmt. In das Training des künstlichen neuronalen Netzes gehen diese Merkmale mit ein. (Bild: Volume Graphics GmbH)

Es ist bisweilen eine Herausforderung, Defekte in einem mittels CT erstellten 3D-Volumen-Modell eines Bauteils zuverlässig zu erkennen und zu bewerten. Der Computertomograph blickt zwar tief, aber was er sieht, ist nicht immer klar. Das gilt insbesondere für komplexere Metall- und Mehrkomponentenbauteile. Auch erfahrene Qualitätstechniker kommen in kniffligen Fällen zu unterschiedlichen Einschätzungen. Was sind Unregelmäßigkeiten im Gefüge, was Artefakte oder wirkliche Materialdefekte? Gewiss, es lassen sich einige Parameter beim Scannen und bei der Auswertung feinjustieren, wobei das Augenmerk häufig auf bestimmte Regions of Interest (ROI) des untersuchten Objekts zu richten ist. Das ist die klassische Herangehensweise. Auch lässt sich die Qualität mit Hilfe der Auflösung und der Scanzeit steuern – je hochauflösender und länger die Scans, desto klarer bilden sich Defekte ab. Doch diese Maßnahmen, wie auch häufige Justageprozeduren, nehmen viel Zeit in Anspruch und verursachen Kosten. Gerade in der produktionsnahen Anwendung, wo vollautomatische Auswertungen verlangt werden, hat die Qualitätssicherung eines nicht: Zeit. Der Produktionstakt steht über allem. Dr. Sven Gondrom-Linke, Head of Technical Consulting bei Volume Graphics: „Die klassische Methode in der Defekterkennung ist innerhalb vollautomatischer Szenarien limitiert. Sie verlangt von den CT-Daten eine Mindestqualität, manuelle Auswertungen führen außerdem zu subjektiv gefärbten Ergebnissen. Die Konsequenz ist, wir benötigen eine Methode, die auch bei geringerer Bildqualität Bauteilfehler zuverlässig findet, unabhängig von äußeren Einflüssen.“

Bild 2 | Bei realistisch simulierten Defekten sind die Voxel, die zum Defekt gehören, bekannt. V.l.n.r.: Simulierte CT-Aufnahme, präzises Defekt-Polygonnetz, präzise Annotation für jedes Voxel. (Bild: Volume Graphics GmbH)

Deep Learning für CT

Ein Seitenblick auf andere Bereiche der Technik mit ähnlichen Ausgangslagen führt zum Thema Deep Learning. Das autonome Fahren, die Sprach- oder Bilderkennung, um nur drei Beispiele zu nennen, bedienen sich dieser Methode schon seit längerem. Sie ist eine Variante des Machine Learnings. Beides fällt unter den Oberbegriff der künstlichen Intelligenz, wobei die Deep-Learning-Methode auf künstlichen neuronalen Netzen (KNN) fußt. Das Vorbild dieser Netze, die im Übrigen bereits seit den 1940er Jahren bekannt sind, ist das Gehirn. Was in der Biologie die Neuronen bzw. Nervenzellen sind, sind in der künstlichen Welt miteinander verknüpfte mathematische Funktionen, die je nach Input einen bestimmten Output berechnen. Bei einer Anwendung in der CT-basierten Defekterkennung hätte so ein Netz die Aufgabe, Materialfehler zu finden und zu kennzeichnen. Intern arbeitet ein KNN mit Gewichtungen, d.h. nach Überschreiten eines bestimmten Schwellenwertes, wird ein entsprechender Output weitergegeben. Das Gebilde benötigt dafür so etwas wie ein Gedächtnis. Auf eine Anwendung in der CT bezogen bedeutet dies: das KNN ist mit Defektdaten zu trainieren. „Als Hauptarbeit beim Aufbau eines KNN für unsere Zwecke hat sich die Aufbereitung der Trainingsdaten erwiesen“, sagt Dr. Sven Gondrom-Linke. „Es macht bei der Erstellung eines speziellen neuronalen Netzes daher Sinn, das zu untersuchende Bauteilespektrum einzugrenzen. Wir entschieden uns, den Fokus zunächst einmal auf Bauteile aus Leichtmetallguss mit typischen Materialfehlern wie Gasporen, Lunker etc. zu richten.“

Defekte aus der Simulation

Im grauwertbasierten CT-Bild zeichnen sich Gussfehler als dunkle Bereiche ab. Die Frage, die sich der Qualitätstechniker dabei stellt, ist stets: Welche Voxel gehören zum Defekt und welche nicht? (Voxel=kleinstes 3D-Element im CT-Modell, ähnlich Pixel im 2D-Bild.) Überlässt man die Annotation, d.h. die Markierung der Voxel entweder als Defektvoxel oder kein Defektvoxel einer Reihe von Labortechnikern, so stehen sich am Ende, meist unterschiedliche Detaileinschätzungen gegenüber. „Für das Training des KNN schied diese Herangehensweise daher aus“, erklärt Patrick Fuchs, Software Engineer bei Volume Graphics. „Wir entwickelten stattdessen eine vollautomatische Annotation mit Hilfe einer Simulations-Pipeline.“ Dafür entwarfen die Heidelberger CT-Spezialisten verschiedene CAD-Modelle von realistischen Aluminiumwerkstücken, gespickt mit typischen Details wie Bohrungen, Gewinden, Nuten usw. Ein nächster Arbeitsschritt bestand darin, reale Defekte, wie sie in Aluminiumbauteilen vorkommen, genau zu analysieren. „Mit diesen Erkenntnissen“, so Fuchs weiter, „entwickelten wir einen Algorithmus, der nach realen Vorbildern ca. 700.000 Defekte generierte, die wir als Mesh-Modelle abgespeichert und in den CAD-Modellen platziert haben. Der Algorithmus erzeugte die Defekte mit zufälligen Formen, aber nach einheitlichen Mustern. Poren haben z.B. immer eine runde Form, Lunker sind aufgerissen und haben viele Ecken und Kanten.“ Im nächsten Schritt bediente sich Volume Graphics der Simulationssoftware aRTist der Bundesanstalt für Materialforschung und -prüfung (BAM), um aus den CAD-Modellen mit ihren Defekten realitätsgetreue CT-Projektionen zu erzeugen (s. Beitrag auf S. ??). Diese bilden die Ausgangsdaten, die auch der Computertomograph in der realen Welt ausgibt. Effekte wie Streustrahlungen oder Artefakte wurden von der Software ebenfalls simuliert. Die so erhaltenen CT-Rohdaten wurden schließlich mit VGinLine zu Voxelmodellen rekonstruiert.

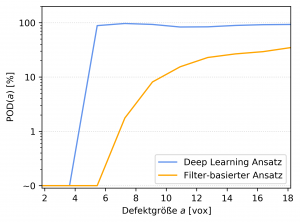

Bild 3 | Die Probability of Detection (PoD) zeigt, dass die Deep-Learning-Methode kleinere Defekte findet als der klassische filterbasierte Ansatz. Auf der x-Achse sind die Defektgrößen nach Anzahl der Voxel aufgetragen. Bereits bei weniger als 4 Voxeln steigt die Kurve schnell an. Ab einer Defektgröße von etwa 5 Voxeln findet das KNN so gut wie 100% aller Defekte. Die klassische Methode wird erst später fündig und kommt in keinem Falle auf 100%. Getestet wurde der Zusammenhang mit einem schwer zu detektierenden Datensatz mit geringen Kontrasten und hoher Artefaktbehaftung. Ein besseres Abschneiden des filterbasierten Ansatzes wäre möglich, aber nur mit entsprechendem Aufwand (hohe Auflösungen, lange Scanzeiten, lokale Filteranwendung auf Regions of Interest usw.). (Bild : Volume Graphics GmbH)

Training mit präzisen Fehlerdaten

Die Ausgangsfrage – Welche Voxel gehören zum Defekt und welche nicht? – lässt sich für dieses Datenmaterial leicht beantworten: da es sich um simulierte Modelle handelt, sind die Defekte in Gestalt und Ausmaß bekannt. Wenn man das KNN mit diesen Daten trainiert, hat es die typischen Defektformen von Aluminiumbauteilen quasi intus. „Es ist elementar wichtig, das Netz mit präzisen Daten zu trainieren, um später genaue Ergebnisse zu erhalten“, betont Patrick Fuchs, „denn das KNN soll Ähnlichkeiten zwischen den simulierten Defekten und den Defekten neuer, realer Bauteile feststellen.“ Anders gesagt: Ein KNN findet nur, womit es gefüttert wurde. Erstreckt sich das Training nur auf Daten von Poren, wird es nur Poren finden. Die anschließende Evaluierung belegt, dass ein so trainiertes KNN sehr gut funktioniert und den klassischen Methoden in jeder Hinsicht überlegen ist, es findet sogar kleinere Defekte, und zwar problemlos. Zwei Qualitätskennzahlen quantifizieren den Sachverhalt anschaulich (s.Kasten): die Probability of Detection (PoD) und die Intersection over Union (IoU) . Die PoD kommt auch sonst in der Qualitätstechnik zu Anwendung. Sie ist ein Kriterium, ob Defekte überhaupt gefunden werden bzw. ab welcher Größe. Die IoU, auch als Jaccard-Index oder -koeffizient bezeichnet, kommt aus der Mengenlehre und wird häufig in der Bilderkennung verwendet. Im hier vorliegenden Anwendungsfall gibt die IoU voxelgenau Aufschluss über die Segmentierungsqualität. Wichtig dabei, die Ergebnisse gelten initial nur für Fehler in Aluminiumwerkstücken, worauf das KNN trainiert wurde. Patrick Fuchs dazu: „Hat man aber einmal ein trainiertes Netz vorliegen, ist der Aufwand, es auf andere ähnliche Anwendungen zu trainieren, überschaubar. Die Anwendung auf Kunststoffe oder andere Metallwerkstoffe ist also im Prinzip jederzeit möglich.“

Bild 4 | Die Intersection over Union (IoU) zeigt in Prozent, inwieweit die Vorhersagen der KNN voxelgenau mit den realen Annotationen, der Ground Truth, übereinstimmen. Dem Diagramm oben liegt ein Evaluierungsdatensatz mit 54 Defekten zugrunde. Eine niedrige IoU, bedeutet, dass bei der Beantwortung der Ausgangsfrage („Welche Voxel gehören zum Defekt, welche nicht?“), viele Voxel falsch interpretiert wurden. Dies kommt auch bei der herkömmlichen Experten-Annotation sehr häufig vor. Der Wahrscheinlichkeits-Schwellenwert auf der X-Achse (0 = kein Defekt, 1 = Defekt) zeigt, stark vereinfacht gesprochen, dass die Deep-Learning-Methode die robusteren Ergebnisse liefert. Der Übergang Defekt/nicht Defekt ist schärfer. Die klassische Vorgehensweise zeigt im Vergleich dazu eine große Streuung. (Bild Volume Graphics GmbH)

Referenzmodelle nicht nötig

Erstes Fazit: Die Deep-Learning-Methode ist bei geringeren Auflösungen und schlechteren Datenqualitäten weit treffsicherer als herkömmliche Methoden und entlastet den Nutzer von der Abstimmung vieler Scan- und Analyseparameter. Sie liefert zuverlässigere Fehleranalysen und fördert generell kleinere Defekte zu Tage.

Zurück zur Inline-Situation mit ihren knappen Prüfzeiten. Die Anwender greifen häufig zu Referenzmodellen von Gutbauteilen für Soll-Ist-Vergleiche. Auf diese Weise lassen sich Abweichungen sicher erkennen. Wenn sich die Bauteile aber ändern, etwa durch Abweichungen im Gießprozess, durch Streuungen in der Werkstoffqualität oder bestimmter Prozessparameter, ist diese Vorgehensweise problematisch und macht Nachbewertungen notwendig. Nachbewertungen in einer Größenordnung von 20 bis 25% sind in der Praxis die Regel.

Zweites Fazit: Die Deep-Learning-Methode funktioniert referenzlos und damit zu jeder Zeit und mit allen Bauteilen in gleicher Weise effektiv. Sie macht Nachbewertungen weitgehend überflüssig. Volume Graphics plant bereits, die Methode in künftige Releases der Analysesoftware zu implementieren. Das Training des KNN werden die Heidelberger CT-Spezialisten vornehmen. Neben den beschriebenen Grundzügen des Ansatzes wird dann auch eine Klassifizierung der Defekte enthalten sein. Dem Anwender darf also ein leistungsstarkes Werkzeug erwarten, mit dem er viel Zeit und Kosten sparen kann.