Deep Learning mit Time-of-Flight-Sensorik für Einsteiger

Die Kombination von Time-of-Flight Kameras und Deep Learning ermöglicht es komplexe Aufgaben zeit- und kosteneffizient zu lösen, da das Anlernen der neuralen Netze von der räumlichen Information stark profitiert. Zudem erlaubt die 3D-Punktwolke ein genaues Positionieren und Vermessen von Objekten.

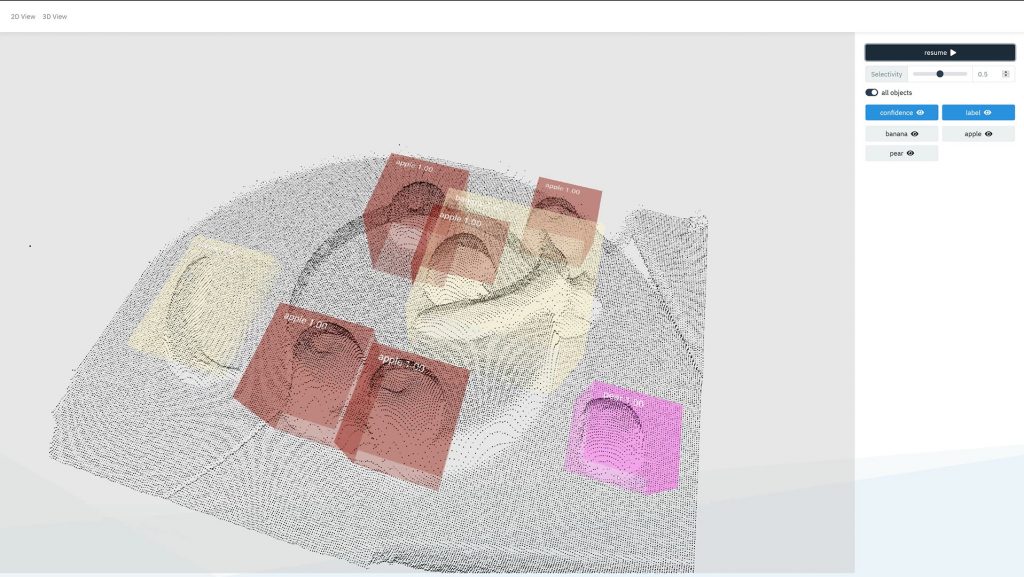

Mit einer ToF-Kamera und Deep Learning können detektierte und klassifizierte Früchte auch dreidimensional im Raum verortet werden, um z.B. in Sortieranlagen die genaue Position an einen Roboter zu übergeben. (Bild: Data Spree GmbH)

Die Stärken von Deep Learning basierter Bildverarbeitung treten besonders bei einem hohen Variantenreichtum der zu untersuchenden Gegenstände auf. Ein gutes Beispiel hierfür ist die Sortierung und Verarbeitung von landwirtschaftlichen Erzeugnissen. Diese können sich in Form und Farbe stark voneinander unterscheiden, was klassische Bildverarbeitungsmethoden vor große Herausforderungen stellt. Zusätzlich erschweren oft unterschiedliche Lichtverhältnisse das Erstellen von generalisierten Lösungen, wodurch RGB-Kameras nur noch einen geringen Vorteil gegenüber Graustufenaufnahmen bieten. Abhilfe schaffen hier 3D-Kameras, wie die blaze von Basler, die über die Time-of-Flight (ToF) Methode nicht nur Graustufenaufnahmen als Intensitätsbild erzeugen, sondern zusätzlich, über Laufzeitmessungen von Lichtimpulsen im NIR, Distanzmessungen für jeden einzelnen Pixel vornehmen. Die resultierende Aufnahme kann anschließend als 2D-Tiefenbild oder als 3D-Punktwolke weiterverarbeitet werden und liefert zusätzliche Informationen über die abgebildete Szene. Im Vergleich zu 2D-RGB-Aufnahmen werden hier die Farbinformationen durch Forminformationen ersetzt, welches nicht nur Vorteile bei der gleichzeitigen Erkennung von roten und grünen Äpfeln hat, sondern zusätzliche Applikationen ermöglicht, wie z.B. das genau Positionieren und Vermessen der erkannten Objekte.

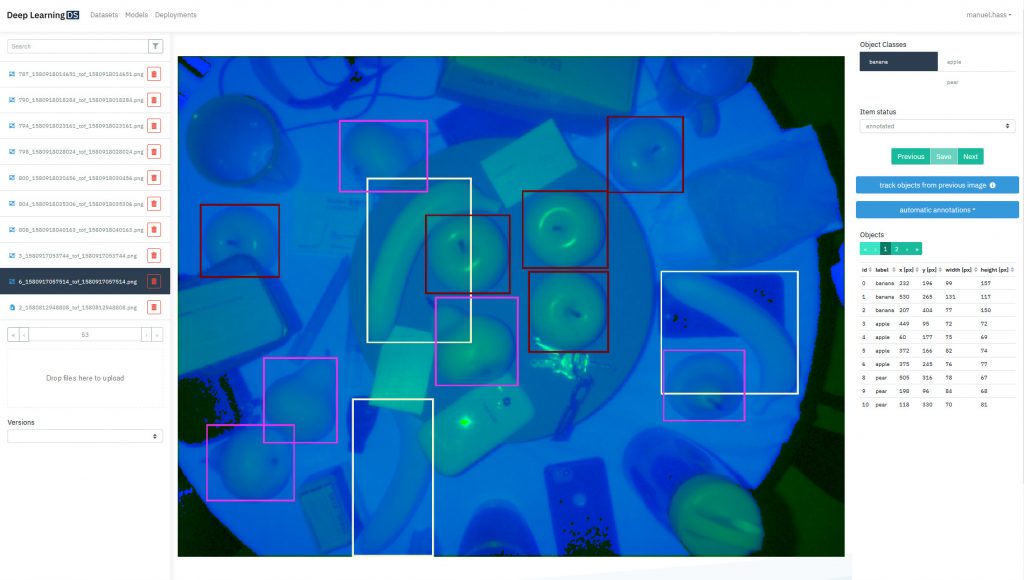

Mit der Deep Learning DS KI-Plattform von Data Spree können Echtzeitlösungen auch ohne jegliche Programmier- und Deep Learning Vorkenntnisse entwickelt werden. (Bild: Data Spree GmbH)

Eigene Deep Learning Lösung

In einer Beispielanwendung für die Detektion und Klassifikation von Früchten sieht man, wie man mit der 3D-Kamera und der Deep Learning DS KI-Plattform von Data Spree eine Echtzeitlösung entwickelt, ohne jegliche Programmier- und Deep Learning Vorkenntnisse. Durch die Tageslichttauglichkeit und die IP67 Schutzklasse der Kamera lässt sich diese Lösung auch direkt auf mobilen Arbeitsmaschinen in rauen Umgebungen einsetzen. Allgemein lässt sich der Arbeitsablauf für die Erstellung von Deep Learning Modellen in fünf Abschnitte unterteilen:

– Datenakquise (Aufnahme von Beispielbildern)

– Annotation (Anreichern mit Metadaten)

– Training (Optimieren des Deep Neural Networks)

– Deployment (Ausführen des Netzes auf der Zielhardware)

– Kontinuierliche Verbesserung des neuronalen Netzes durch neue Daten

Da diese Schritte zunächst nach einer großen Herausforderung klingen, wurde mit Deep Learning DS eine Plattform entwickelt, um es dem Anwender so leicht wie möglich zu machen, in kürzester Zeit seine eigene Deep-Learning-Lösung zu entwickeln:

Datenakquise: Zunächst müssen Bilder von den Früchten aufgenommen werden, welche später erkannt und klassifiziert werden sollen. Für diese Anwendung wurden ca. 500 Bilder von Bananen, Äpfeln und Birnen aufgenommen. Die Aufnahmesoftware erstellt 2-Kanal-Bilddaten aus der Graustufen-Intensitätsaufnahme und dem Tiefenbild, welches für jeden Pixel den Abstand in Millimetern enthält. Die Bilddaten werden direkt in die Deep Learning Plattform geladen.

Annotation: Anschließend werden die Daten mit Metadaten angereichert. Dazu werden manuell Boxen um die Früchte gezeichnet und die entsprechende Kategorie (Apfel, Birne etc.) zugeordnet. Damit wird festgelegt, was das neuronale Netz im folgenden Schritt lernen soll. Der Prozess kann bereits nach circa 100 manuell annotierten Bildern beschleunigt werden, indem ein initiales Deep Learning Modell Vorschläge für die weiteren Aufnahmen generiert, die der Anwender anschließend nur noch korrigiert.

Training: Sind alle 500 Bilder annotiert, erfolgt über wenige Mausklicks die Erstellung und das Training eines weiteren Modells. Abhängig von der Datenmenge und der Komplexität der Aufgabe dauert dieser Prozess zwischen wenigen Stunden und einem Tag. Während des Trainings wird die Erkennungsgenauigkeit zyklisch auf einem vorenthaltenem Testdatensatz geprüft, um die aktuelle Güte des Modells abzuschätzen. Sobald eine hinreichende Genauigkeit erreicht ist, läuft das Training noch etwas weiter, um die Robustheit der Erkennung weiter zu verbessern.

Deployment und Inferenz: Sobald das Training abgeschlossen ist, wird das fertig trainierte Modell heruntergeladen und direkt über die Ausführungssoftware Inference DS ausgeführt. Zahlreiche USB-, Netzwerk- und gängigen Industriekameras sowie die blaze ToF Kamera (inklusive entsprechender Vorverarbeitung) sind bereits vollständig integriert, sodass die Deep Learning Applikation direkt gestartet werden kann. Mit der zusätzlichen Tiefeninformation der ToF-Kamera können die detektierten Früchte auch dreidimensional im Raum verortet werden, um z.B. in Sortieranlagen die genaue Position an einen Roboter zu übergeben.