Fünfmal schnellere Deep-Learning-Inferenz

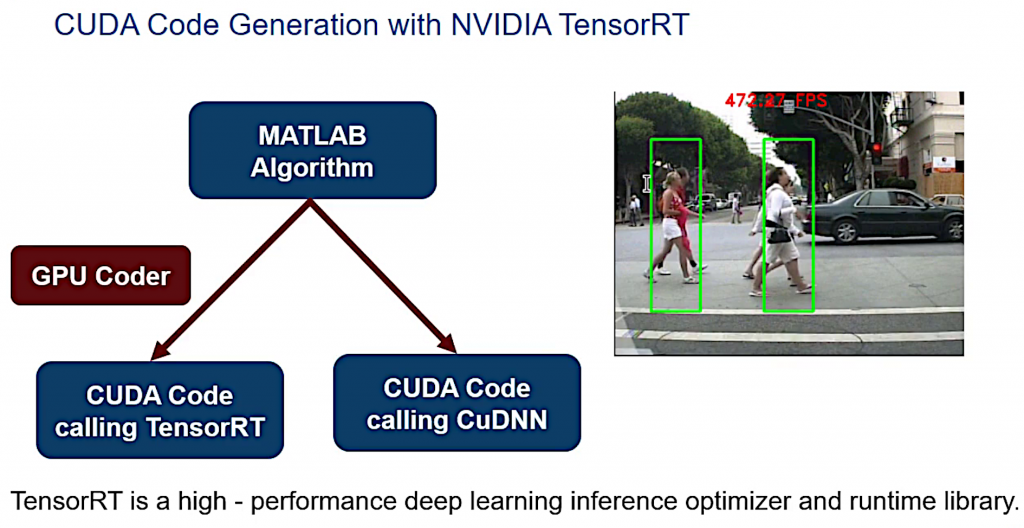

Matlab bietet ab sofort eine Integration von Nvidia TensorRT über GPU Coder. Dies erleichtert die Entwicklung neuer Modelle für KI und Deep Learning in Matlab.

Dank der neuen Integration können in Matlab entwickelte Deep-Learning-Modelle auf Nvidia-GPUs mit hohem Durchsatz und geringer Latenz ausgeführt werden. Interne Benchmarks zeigen, dass von Matlab generierter Cuda-Code in Kombination mit TensorRT Alexnet mit fünfmal höherer Leistung und VGG-16 mit 1,25-mal höherer Leistung bereitstellen kann als die Deep-Learning-Inferenz der entsprechenden Netze in TensorFlow.