Machine Vision goes Embedded

Schnittstellen Sensor-Board und Prozessor-Einheit/SoCs

Smartphones und Tablets haben unsere Sicht auf Bildaufnahme- und -verarbeitungskapazitäten von Kleinstcomputern verändert. Hohe Video- und Datenbandbreiten, bei gleichzeitig steigender Verarbeitungsleistung und niedrige Energiewerte, sowie eine fortschreitende Miniaturisierung bei höherer funktionaler Komplexität, haben das Interesse der Bildverarbeitung geweckt. Traut man aktuellen Umfragen, wird Embedded Vision einer der Technologietreiber der Zukunft sein. Aber welche Standards werden Embedded Vision und smarte Kameras für die Zukunft benötigen?

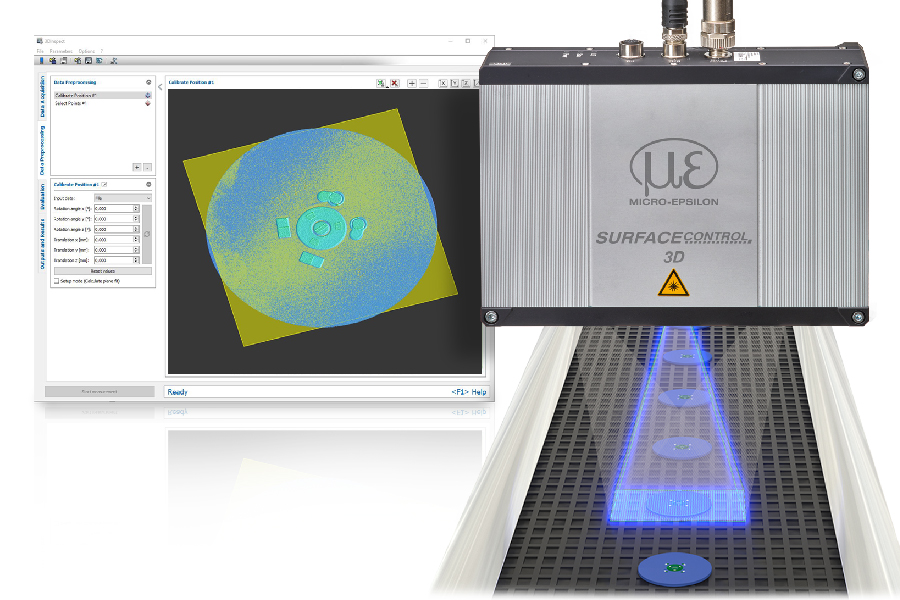

Als Abgrenzung zu ‚klassischen‘ Bildverarbeitungssystemen, die aus einer Vielzahl von Komponenten bestehen (Beleuchtung, Optiken, Kameras, Sensoren, Bildaufnahme- und -speichergeräte, Netzwerk-/Feldbusanbindungen…), definieren sich Embedded-Vision-Systeme über die Einbindung von Embedded IPCs als PXI-Plattform oder industrielle Ein-Platinen-Computer. Smart Cameras hingegen bestehen aus Sensoren und Prozessoreinheiten in einem kompakten und robusten Gehäuse, optional ausgestattet mit Beleuchtung und Optik. Die Softwareumgebung ist häufig proprietär und funktional fest definiert. Für die Untersuchung der EVSG (s.Kasten) wurden die Embedded IPCs nicht weiter betrachtet, um ein aussagekräftiges Modell zu erarbeiten. Die Anforderung an die Leistungsfähigkeit eingebetteter Systeme lehnt sich an klassische Vision-Systeme an, zusätzlich mit den Ausprägungen:

Smart: Embedded-Intelligenz

Small: Kleiner Formfaktor

Simple: Einfache Handhabung bei Usability und Softwareintegration

Um Anforderungen und Lösungsansätze zu erarbeiten, wurden von der ESVG drei Technologiefelder (SC=Standard Candidate) identifiziert, für die Arbeitsgruppen eingerichtet wurden.

SC1: Schnittstelle zwischen den Sensor-Boards und der Prozessor-Einheit/ System-on-a-Chip (SoCs)

SC2: Software API

SC3: Schnittstelle zwischen der Kamera und der Verarbeitungsumgebung

Schnittstelle Sensor-Board / Prozessor-Einheit

Die Bildverarbeitung bietet eine große Auswahl an Transportschichten für eine Verbindung zwischen einer Kamera und einem klassischen Desktop IPC bzw. Embedded IPC. Beispiele hierfür sind Camera Link (HS), CoaXPress, GigE Vision oder USB3 Vision. Die beste Option hängt jeweils von der Anwendung und deren Anforderungen ab, z.B. Bandbreite, Datenübertragungsformat, Robustheit, garantierte Signalintegrität, Distanzen zwischen Komponenten, Spannungsversorgung der Kamera oder auch Latenzen der Signalsteuerung. In einer Smart-Kamera unterscheiden sich Anforderungen an die Schnittstelle zwischen Sensorplatine und Verarbeitungseinheit bzw. SoC. Neben Bandbreite, Formfaktor der physikalischen Schnittstelle und des Steckers, sind die maximale Leitungslänge, die Energiewerte für Stromverbrauch und Wärmeableitung, die Definition der Industriequalität, Produktverfügbarkeit sowie Kosten weitere wichtige Entscheidungsfaktoren. Schwerpunkt der SC1 ist die Untersuchung, welche Schnittstelle diese Anforderungen am besten erfüllt.

Globale Trends als Thema

Videoaufnahmen und -verarbeitungen sind inzwischen in mobilen Geräten implementiert und funktionieren mit hoher Performance. Diese Technologien können auch für Embedded-Systeme eingesetzt werden. Allerdings werden in dieser Branche keine industriellen Sensoren verbaut oder langfristige Liefergarantien zugesagt, noch existiert eine Schnittstelle zwischen dem Sensor und einem FPGA, um z.B. BV-Protokolle zu implementieren. Die Verfügbarkeit von System-on-a-chip (SoC) als Prozessoren, integriert auf Boards und in Kombination mit FPGAs ist auf dem Elektronikmarkt in vielen Ausführungen gegeben. Als Fallbeispiele wurden in der Studie technische Umsetzung in Kameraköpfen, Smart-Sensoren und Vision SoC betrachtet. Die Anforderungsliste an SC1 umfasst dreizehn Einträge (Tab. 3).

Relevante Technologien

Um weit verbreitete Schnittstellenstandards zu untersuchen, wurden Technologien aus speziellen Märkten (Sicherheit, Militär) nicht berücksichtigt. Für eine weitere Betrachtung wurden die Schnittstellen-Technologien MIPI (Mobile Industry Processor Interface), die sich im mobilen Bereich für die Videoübertragung mit seinen Protokollen CSI-2/CPHY, CSI-2/DPHY und CSI-3 durchgesetzt hat, PCI Express, das eine Verbreitung bei vielen Embedded-Zubehör gefunden hat und USB bzw. USB Vision, das auf vielen SoCs und SoC-Modulen zu finden ist und direkt als Vision Standard eingebunden werden kann, ausgewählt. Die Studie untersuchte die Relevanz für Bildverarbeitungsstandards u.a. auf Basis der Physical Layers, Protokolle und Anbindungen zu FPGAs bei MIPI. Für USB3 liegen über USB3 Vision und bei PCI Express über Komponenten bereits tiefgehende Erfahrungen vor. USB3 erfüllt dabei als einzige Schnittstelle alle Anforderungen. Trotz der Möglichkeit, die physikalische Verbindung als Kabel oder board2board Steckverbindung zu designen, gibt es keine Verifizierung, ob diese Verbindungen auch in industriellen Embedded-Systemen verwendbar sind. Der große Vorteil von USB3 liegt in der Software, da diese bereits als Machine Vision Standard vorliegt. Weiterer Kritikpunkt bei anspruchsvollen Anwendungen ist eine limitierte Treiberleistung und hohe CPU-Last. Genau für diese anspruchsvollen Anwendungen ist PCI Express die richtige Wahl. Die Leistungsfähigkeit der Schnittstelle ist hierauf optimiert worden. Die Entwicklungsplanung und Roadmap sind ebenso wie die Technologie gut spezifiziert. Ein Vision Standard müsste analog zu GEV und U3V noch entwickelt werden. Standardisierte Treiber sind nicht vorhanden und es entstehen zusätzliche Entwicklungsaufwände für jedes Betriebssystem. MIPI wurde als der vielversprechendste Kandidat angesehen. Eine hohe Verbreitung, niedriger Energieverbrauch, niedrige Kosten, ausreichend Leistung und einsetzbar für Video Streaming. Dennoch sind der fehlende Transaction Layer zur Software, eine limitierte Unterstützung von FPGAs, eine unklare Roadmap mit Inkompatibilitäten aktueller Protokoll-Technologien wichtige Kritikpunkte für einen industriellen Einsatz. Das Feld der Technologiekandidaten hat heterogene Stärken und Schwächen. Der EVSG war es deshalb nicht möglich, sich für eine einzige Technologie auszusprechen. Das Thema ist jedoch zu wichtig, um es nicht weiterzuführen. Die Empfehlung der Gruppe wurde daher auf eine Untersuchung weiterer Aktionspunkte festgelegt, wie die Integration der SoC-Hersteller in die Diskussion, der Untersuchung der V4L2 (Video for Linux) Option, der Evaluierung der USB3 board2board Verbindungsstecker sowie der Vergleich der Vorteile von CSI-2/PCI Express mit USB3.