Das Ende von FPS*

Sensor reagiert mit 10kHz autark auf Bewegungsänderungen

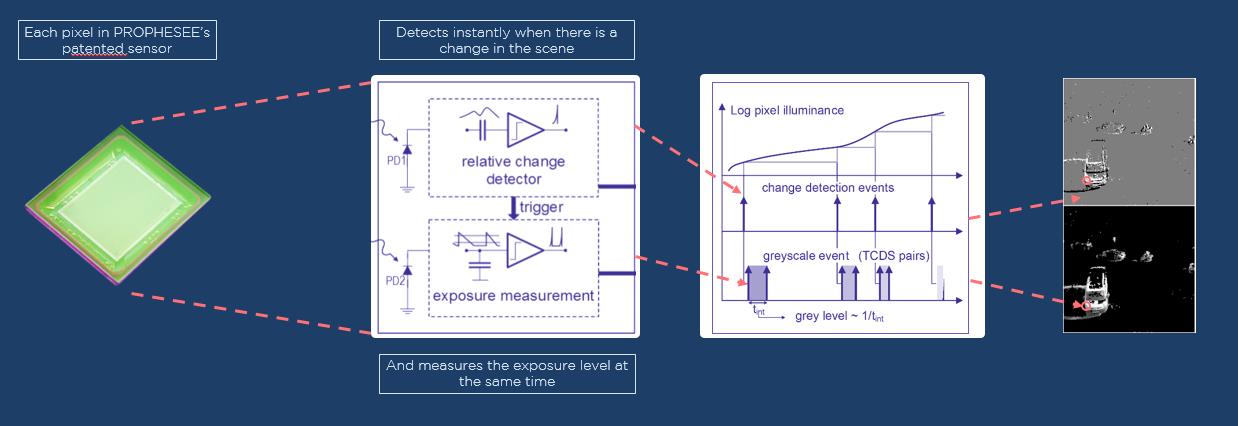

Beim Event-Based Sensor der VisionCam EB reagiert jeder Pixel autark auf Bewegungsänderungen und versendet diese – je nach Änderungsgeschwindigkeit – mit bis zu 10kHz, d.h. bewegt sich nichts, wird auch kein Signal generiert.

Bild 1 | Anwendungsbeispiel: Bewegliches Objekt auf statischem Hintergrund, aufgezeichnet von einer RGB-Kamera (links) und der VisionCam EB (rechts). (Bild: Imago Technologies GmbH)

Es ist an der Zeit völlig neu zu denken. Bereits 1888 hat Louis Le Prince erste Filmaufnahmen ausgeführt. Damals – genau wie heute – wurde ein Bild nach dem anderen aufgenommen. Mittlerweile zwar mit Farb-CMOS-Sensoren, hochauflösend, schnell usw., aber im Prinzip hat sich an der Aufnahmetechnologie in den letzten 130 Jahren nichts verändert. Vergessen wir jetzt einmal ganz bewusst die Funktionsweise einer Videokamera und wenden uns einem völlig neuartigen Konzept zu: Event-Based Vision.

Keine Bewegung, kein Bild

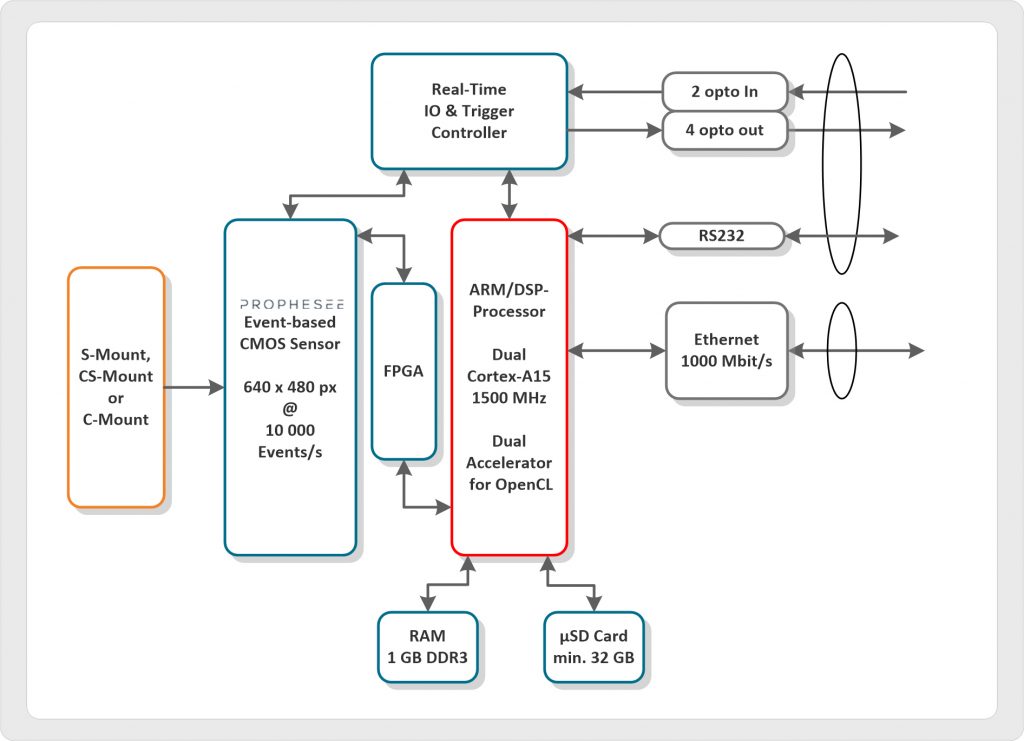

Der Event-based Sensor hat zwar auch eine Matrix von Pixeln, die jedoch anders arbeiten als andere Bildsensoren. Jeder Pixel reagiert autark auf Bewegungsänderungen und versendet diese je nach Änderungsgeschwindigkeit mit bis zu 10kHz. Findet keine Bewegung statt, wird auch kein Signal generiert. Zudem kann jeder Pixel autark seine eigene Belichtungszeit individuell steuern. Eine Empfindlichkeit von 120dB ermöglicht so den Blick auf hochdynamische Szenen. Übersetzt heißt dies: In einem Bild ohne Bewegung liefert der Sensor kein Signal. Also haben Frames per second (fps) hier keine Bedeutung. Bewegungen dagegen erzeugen in den beteiligten Pixeln Signale unterschiedlichster Frequenz. Diese Art des Datenstroms wird direkt an die CPU der intelligenten Linux-Kamera VisionCam EB (Event-Based) gesendet. Die Datenreduktion erfolgt bereits im Sensor, d.h. Bewegungsdaten unterschiedlichster Geschwindigkeit treffen auf mathematische Algorithmen, die umgehend in der Kamera ausgeführt werden. Hinter der VisionCam EB stehen zum einen Imago Technologies, Spezialist für Embedded Vision Rechner und Kameras, sowie Prophesee aus Frankreich, die den Event-Based Sensor entwickelt haben. Natürlich sind typische Bildverarbeitungsbibliotheken wie z.B. Halcon (noch) nicht für Event-Based Anwendungen ausgelegt. Allerdings steht Anwendern bereits eine eigene Bibliothek von Prophesee zur Verfügung. Der Kern der VisionCam EB ist ein leistungsstarker Dual-Core ARM Cortex-A15 mit zwei per Open CL programmierbaren Zusatzprozessoren. Der Datenaustausch erfolgt per GigE, wobei mit digitalen IOs die Verbindung zu Sensoren oder einer SPS hergestellt wird. Die Programme sind auf einer µSDCard gespeichert. M12-Konnektoren sind Industriestandard und vermeiden den Ärger mit RJ45-Buchsen. C-Mount-Objektive können optional mit einem Schutztube versehen werden, sodass die VisionCam IP65-geschützt ist.

Anwendungen

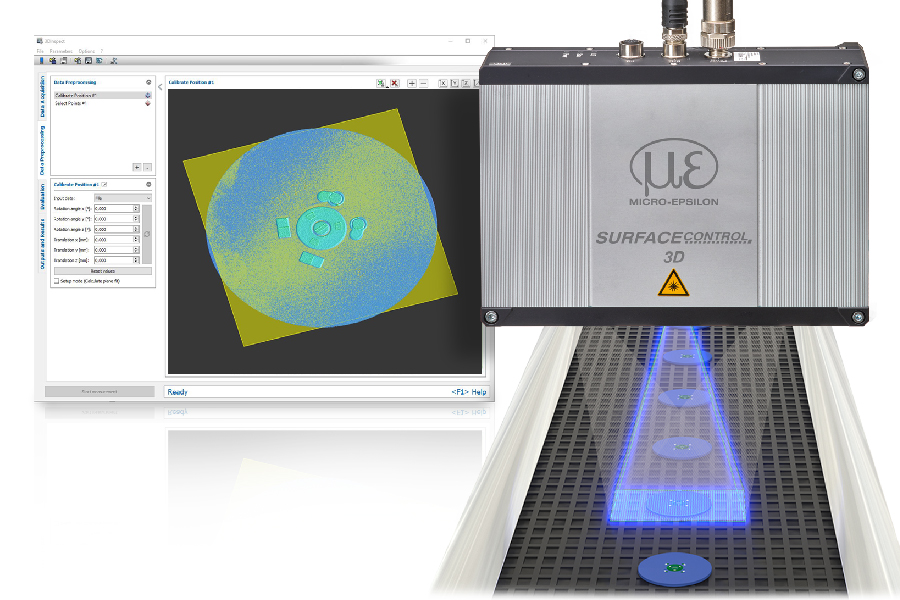

Bei Vision-Anwendungen geht es meist darum, bewegte Objekte zu klassifizieren, z.B. in einer Zählanwendung. Dort ist die Geschwindigkeit der Informationserfassung eine Frage der Bildwiederholfrequenz. 100Hz sind üblich, d.h. im Takt von 10ms gibt es Informationen. Gehen Informationen dazwischen verloren, so muss die Bildwiederholrate erhöht werden, z.B. auf 1.000Hz entsprechend 1ms. Zudem müssen auf dem Vollbild Objekte vom Hintergrund getrennt werden. Dies ist im Durchlichtverfahren noch einfach, aber schwierig bei Auflicht und komplexen Szenen, z.B. bei Bewegungen in einer Maschine oder bei der Vibrationsanalyse. Dabei liefert eine VGA-auflösende Szene mit 1.000Hz bereits 300MB/s. Eine unglaubliche Datenmenge, auch für heutige schnelle Rechner. Erste Referenzanwendungen der VisionCam EB ergeben sich daher bei folgenden Applikationen:

- • Vibrationen: Die Analyse von Vibrationen von Produkten oder Maschinen (Motoren, Aggregate…) ist interessant für die Qualitätsbeurteilung, präventive Wartung, Maschinenregelung oder einen Notstopp

- • Kinematische Analysen: Bewegungsmuster von Maschinenteilen können eingelernt und kontrolliert werden. Bevor z.B. eine Verpackungsmaschine verstopft, ist dies eventuell schon an der Änderung von Bewegungen der Produkte oder von Maschinenteilen erkennbar.

- • Zählvorgänge: Zählmaschinen haben die Aufgabe z.B. Pillen, Kapseln, Schrauben usw. zu zählen. Kunststoffteile oder Gelkapseln müssen dabei aufwändig beleuchtet werden, damit die Formen für den Zählvorgang erkannt werden. Die VisionCam EB registriert sehr schnell Kanten, kann diese verfolgen, Objekte klassifizieren und somit auch zählen.

- • Verkehrstechnik: Bewegte Objekte lösen Signale aus – und es gibt nachweislich keine Bilder, d.h. auch keine Datenschutzprobleme. Kann man mit der Kamera Geschwindigkeiten messen? Oder die Verlegung von Sensoren zur Auslösung einer Rotlichtkamera vermeiden? Wäre es möglich aus einem Zug heraus die Gleise zu tracken und festzustellen, ob Gegenstände oder Personen auf dem Gleis sind? Überragt ein Gegenstand auf einem Waggon vorgegebene Grenzen? Je länger man sich mit dem Event-Based Konzept beschäftigt, desto größer wird die Fantasie, was damit machbar sein könnte.

Bild 3 | Anwendungsbeispiel für die intelligente Kamera VisionCam EB (Event-Based) (Bild: Imago Technologies GmbH)

*frames per second