Neue Bedienkonzepte für Deep Learning auf Smart-Kameras

Für Embedded-AI-Kameras, also Kameras die es ermöglichen neuronale Netze direkt auf Smart Kameras auszuführen, gibt es mittlerweile unterschiedliche Bedienkonzepte, die zum Training der neuronalen Netze angeboten werden.

Hersteller, wie z.B. Flir, IDS, NET oder Basler haben seit kurzem einen neuen Kameratyp im Programm, der es ermöglicht, neuronale Netze direkt auf einer intelligenten Kamera auszuführen. Damit das neuronale Netz trainiert werden kann, ist ein Datensatz nötig. Das Bildverarbeitungssystem hingegen wird klassisch programmiert. Dieser Übergang vom Programmieren zum Lernen stellt den Anwender aber bei der Bedienung vor neue Herausforderungen. Wie umfangreich muss der Datensatz sein, damit die relevanten Informationen enthalten sind? Was ist zu tun, wenn 2% Fehlklassifikation noch (viel) zu hoch sind? Wie kann ich die Robustheit erhöhen, damit das System auch bei Störeinflüssen bei voller Leistungsfähigkeit funktioniert? Wie kann auf geänderte Aufgabenstellungen flexibel reagiert werden? Nicht alle, am Markt verfügbaren Konzepte geben darauf eine Antwort und bieten umsetzbare Lösungen zu diesen Fragen.

Machine Vision as a Service

Folgende Konzepte, bzw. Lösungsvarianten werden derzeit angeboten:

a) Bildverarbeitungsbibliothek mit Deep-Learning-Funktionalität

b) Cloud Workflow: Daten hoch- und neuronales Netz herunterladen

c) Dienstleistung durch externe Experten

d) Machine Vision as a Service

Technisch betrachtet ist der Cloud Workflow die online Version der Bildverarbeitungsbibliothek mit Deep-Learning-Funktionalität. Ziel ist es hier, einem unerfahrenen Nutzer die Möglichkeit zu geben, mit möglichst wenigen Bilddaten ein neuronales Netz zu trainieren. Weil aber in einem kleinen Datensatz nicht alle notwendigen Informationen enthalten sind, wird mit einem technischen Trick gearbeitet, dem sogenannten Transfer Learning. Hierbei wird ein vorhandenes neuronales Netz auf eine neue Aufgabenstellung transferiert. Dazu wird typischer Weise lediglich die letzte vollvernetzte Schicht neu gelernt. Dafür sind nur wenige Minuten Trainingszeit notwendig und Datensätzen mit nur 100 Bildern können ausreichend sein. Nachteilig ist die erzielbaren Klassifikationsleistungen. Zum einen stehen dem Training aufgrund des kleinen Datenumfangs nur wenige Informationen zur Verfügung, zum anderen sind die ersten Schichten des neuronalen Netzes, die für die Informationsextraktion zuständig sind, nicht auf die neue Aufgabenstellung optimiert. Interessanter Weise stellen die Hersteller von Embedded-AI-Kameras einen entsprechenden Workflow zur Verfügung, teilweise auch als Cloudlösung, was aber die angesprochenen Probleme nicht löst.

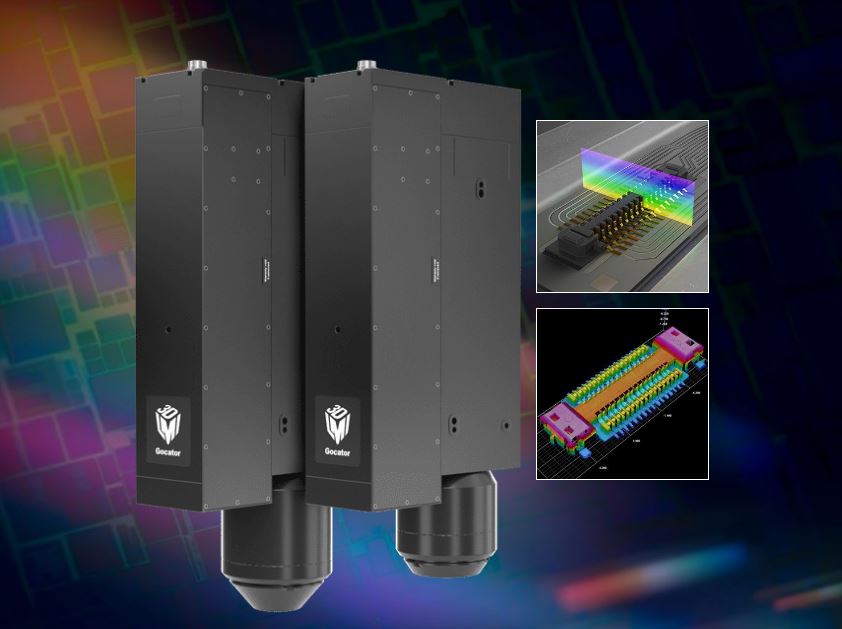

Das Inspektionssystem Gixel AI ist in der Lage, innerhalb weniger Minuten aus einer kleinen Anzahl an Beispielen eine Genauigkeit auf Produktionsniveau zu erreichen. (Bild: Gixel GmbH)

Möchte man die Klassifikationsgüte oder Robustheit weiter steigern, lohnt es sich auf Expertenwissen zurück zu greifen. Technisch ist es das Ziel, ein neuronales Netz von Grund auf neu zu lernen. Wird dazu ein externer Dienstleister beauftragt, ist man im Projektgeschäft mit all seinen Vor- und Nachteilen (Reaktionszeit auf Änderungen, Mehrkosten?) konfrontiert. Das Fraunhofer Spin-Off Gixel bietet dagegen mit Machine Vision as a Service eine Alternative. Hierbei werden nicht nur die Daten in eine Cloud geladen, sondern die Embedded-Kamera selbst ist mit der Cloud verbunden. Dadurch wird auch die Erstellung des Datensatzes als Dienstleistung übernommen und entsprechend große Datensätze aufgebaut. Die externe Dienstleistung ist somit in einem Standardprodukt gekapselt und kann on Demand genutzt werden. Das Inspektionssystem Gixel AI besteht aus einem vorkonfiguriertem IPC optimiert für die Inferenz komplexer neuronaler Netze. Dieser wird vorkonfiguriert mit Touchscreen geliefert und lernt in wenigen Minuten die Klassifikationsaufgaben ein. Das Gixel AI Team übernimmt den weiteren Lernvorgang über das Internet. Während dem Einlernen vergehen typischer Weise vier Sekunden zwischen Bildaufnahme und Klassifikationsergebnis. Danach liegt die Klassifikationsgüte meist bereits auf Produktionsniveau. Ist der Lernvorgang abgeschlossen, kann die Verbindung zum Internet getrennt werden. Nachlernen durch erneute Anbindung an den Server ist jederzeit möglich.

Gixel AI kann entweder als Komplettlösung mit einem vorkonfigurierten IPC genutzt werden oder mit einer Embedded-AI-Kamera, welche temporär zum Einlernen mittels einer zusätzlichen Hardware mit der Gixel-Cloud verbunden wird. Als Alleinstellungsmerkmal steht das System bereits während der Einlernphase produktiv zur Verfügung. Dazu wird das Prüfergebnis während dem Einlernen in Echtzeit mit einer typischen Latenz von vier Sekunden in der Cloud berechnet. Der Anwender muss für Änderungen oder Neuerstellung einer Prüfaufgabe nur wenige Minuten lang Beispielbilder klassifizieren. Ist der Datensatz für die Aufgabenstellung ausreichend groß, wird das trainierte Neuronale Netz auf die Embedded-AI-Kamera geladen. Nun sind herstellerabhängig sehr hohe Frame-Raten möglich und eine Internetverbindung nicht mehr notwendig.

Fazit

Deep Learning ermöglicht bessere Bildverarbeitung und weniger Fehlklassifikationen, aber die Bedienbarkeit wurde bisher in der Praxis nicht gelöst. Machine Vision as a Service bietet hier einen neuartigen Ansatz, schnell und intuitive auf Prozessänderungen zu reagieren. Dadurch werden Embedded-AI-Kameras in der Anwendung beherrschbar und die Leistungsfähigkeit der Deep-Learning-Technologie steht jedem zur Verfügung.