Deep Learning zur Oberflächenprüfung von Metall und Kunststoff

Die KI-Software AI.See von Elunic wird häufig zur Prüfung von Oberflächen aus Metall und Kunststoff eingesetzt. Mit einem Starterkit und einem Smartphone können Anwender selbst einen ersten Eindruck einer KI-basierten Qualitätsprüfung gewinnen.

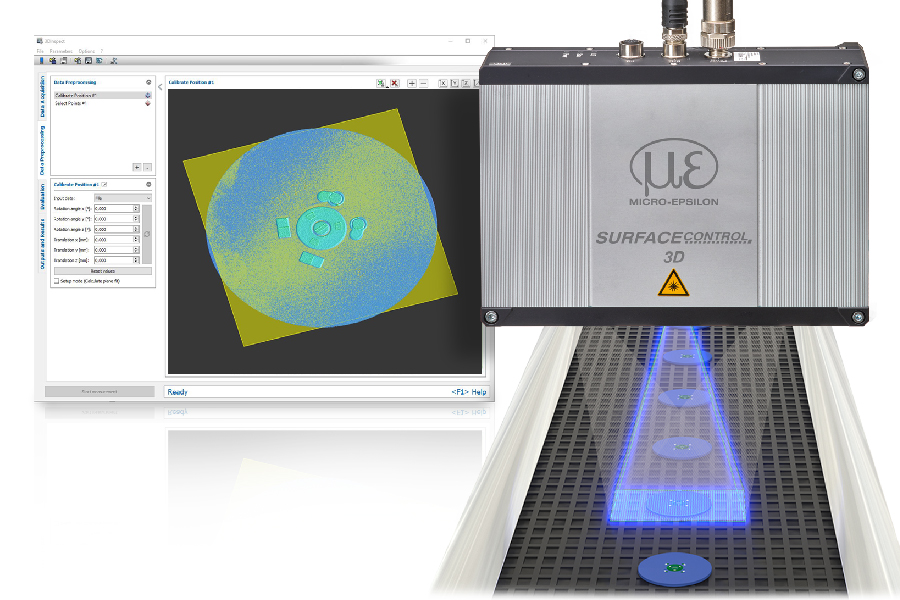

Für die Installation der KI-Software AI.See stehen Anwender-spezifische Komplettpakete mit Kamera, Beleuchtung und IPC zur Verfügung. Die Lernphase des KI-Systems erfolgt im laufenden Betrieb. (Bild: Elunic AG)

Ein Beispiel für den Einsatz von Deep Learning ist die Erkennung von Lunkern in Guss-, Spritzguss- oder Betonteilen. Diese kleinen, durch Schwindung bedingten Vertiefungen können in Größe, Form und Lage völlig unterschiedlich aussehen. Regelbasierte Systeme lassen sich deswegen nur schwer einsetzen. AI.See dagegen erfasst durch einen Lernvorgang das generelle Prinzip des Lunkers. Einmal trainiert, erkennt es die Fehler in Echtzeit. Das gleiche Prinzip gilt auch für Kratzer, Risse und Unebenheiten auf Metall- und Kunststoffteilen oder defekte Leiterbahnen auf Platinen.

Lernphase im laufenden Betrieb

Zur Installation stehen anwenderspezifische Komplettpakete zur Verfügung. Die Montage der Kamera erfolgt an einem flexiblen Arm, wobei die Kameraauflösung entsprechend der Prüfobjekte gewählt ist. Neben der Beleuchtung gehört auch eine Edge Computing Recheneinheit zum System. Die Datenmengen zur Weiterentwicklung der KI-basierten Erkennung befinden sich in der Cloud. Die Lernphase des KI-Systems erfolgt im laufenden Betrieb. Der Einstieg beginnt anhand von als fehlerhaft/fehlerfrei eingestuften Bildern. 1.000 Bilder sind ein guter Anfang. Abhängig von der Problemstellung ist aber auch mit 100 Bildern der Start der Qualitätsprüfung möglich. Die Software benötigt in der Anfangsphase Unterstützung durch einen Bediener, der Grenzfälle entsprechend zuordnet, wobei der Unterstützungsbedarf stetig geringer wird. Nach etwa zwei Monaten funktioniert die Fehlererkennung in der Regel sehr gut. Der Mitarbeiter muss nur noch vereinzelt eingreifen. Je mehr Fehlerbilder (>1.000) zu Projektbeginn vorliegen, desto kürzer ist die Lernphase. Schon bald muss der Mitarbeiter nur Fälle prüfen, bei dem die Software nicht eindeutig erkennt, ob ein Fehler vorliegt. Die Person markiert dann ggf. einen Fehler und erzeugt damit ein weiteres Trainingsbild. Auf diese Weise lernt die Software kontinuierlich weiter und wird immer besser. Durch Transfer Learning lässt sich die Trainingszeit der Software zudem weiter verkürzen. Hierbei werden ähnliche, anonymisierte Produktdaten anderer Anwendungen zur Erkennung von Fehlern genutzt. Schließlich sehen Kratzer, Verschmutzungen und Lunker oft ähnlich aus. Eine Besonderheit der Software liegt in der zeitlich unbefristeten Korrektur. Die Lernphase gilt nie als abgeschlossen. Stattdessen prüft der Mitarbeiter weiterhin Grenzfälle, die AI.See nicht selbst einordnen kann.

Starterkit mit Smartphone

Als Architektur setzt Elunic auf Edge Computing. Alle Berechnungsvorgänge, die schnelle Reaktionen erfordern, bearbeitet der vor Ort installierte Industrie-PC. Dazu gehören die Auswertung der Videos aus der laufenden Produktion und zugehörige Aktionen, wie Signalisierung und Ausschleusung von Produkten sowie das fortlaufende Training der neuronalen Netze. Aktuell wird die Cloud nur initial für die Machbarkeitsstudie genutzt, am Ende läuft die Inspektion – auch das Training – auf dem lokalen Server. Bei Bedarf können aber große Datenmengen für eine historische Analyse der Produktionsfehler in der Cloud gespeichert werden. Interessenten können die Software mit einem Starterkit selbst testen. Zum Kit gehört ein flexibler Arm, an dem allerdings ein Smartphone anstatt einer Kamera befestigt wird. Die Software im Smartphone wird zunächst mit einigen Gut-/Schlecht-Bildern aus der Anwendung gespeist. Dann beginnt die Software mit der Erkennung von Defekten und legt unklare Produktbilder dem Mitarbeiter zur Prüfung vor. Durch das Starterkit können die Qualitätsprüfer selbst einen ersten Eindruck einer KI-basierten Qualitätsprüfung gewinnen.