Was ist Deep Learning?

Deep Learning für heutige Machine Vision Systeme

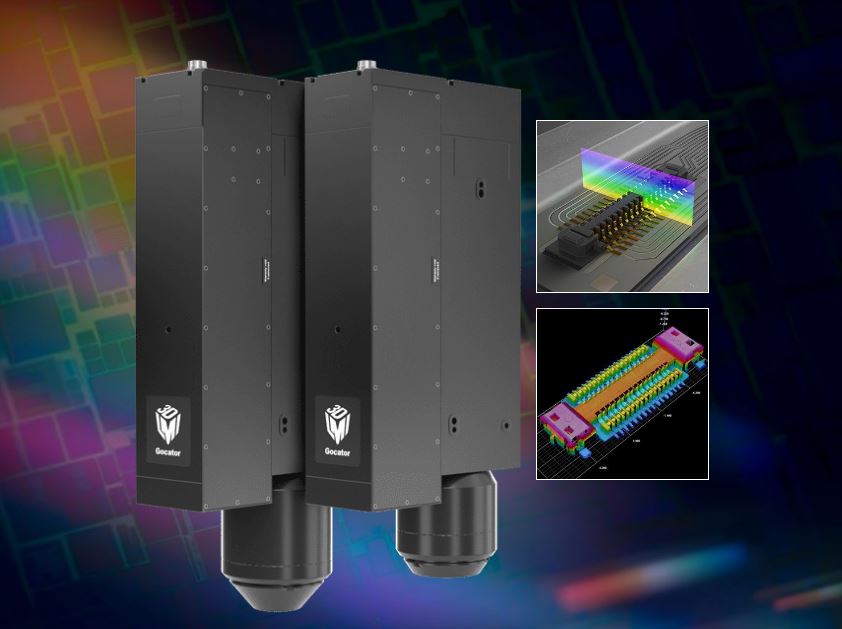

Von Bildverarbeitungssystemen wird immer häufiger erwartet, dass sie automatische Entscheidungen basierend auf variablen Bedingungen treffen. Deep Learning kann helfen, diese Systeme schneller zu entwickeln. Einige Kameras verfügen zudem über die nötige Bildvorverarbeitung, um das neuronale Netzwerktraining auf ein Minimum zu begrenzen, und ermöglichen eine Zusammenarbeit mit Plattformen wie Nvidia Jetson TX-2 und Drive PX 2.

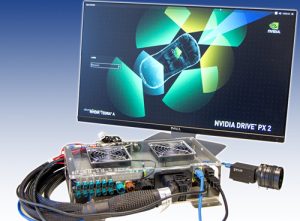

Deep Learning Plattform Nvidia Drive PX2 mit einer Grasshopper3 USB3-Kamera. (Bild: Flir Integrated Imaging Solutions, Inc.)

Beim Deep Learning werden neuronale Netze mit zahlreichen tiefer liegenden Schichten zwischen den Ein- und Ausgabeknoten genutzt. Nachdem ein Netzwerk das Training mit einem großen Datensatz durchlaufen hat, wird ein Modell erstellt, mit dem basierend auf den Eingabedaten, genaue Vorhersagen möglich sind. In den neuronalen Netzen wird die Ausgabe einer Schicht, als Eingabe an die nächste Schicht übertragen. Die Modelloptimierung erfolgt dabei stufenweise, indem die Gewichtung der Verbindungen zwischen den Schichten geändert wird. In jedem Zyklus wird das Feedback zur Vorhersagegenauigkeit des Modells genutzt, um die Änderungen an der Verbindungsgewichtung zu steuern.

Gründe für den Erfolg

GPU-beschleunigte Hardware: Die Architektur von GPUs, die mithilfe einer großen Anzahl von Prozessoren parallele Berechnungen durchführen können, eignet sich ideal für Deep Learning Systeme. Dank der ständigen Weiterentwicklung durch Nvidia sind GPU-beschleunigte Computing Plattformen heute leistungsstärker, effizienter und kostengünstiger geworden. Die Technologie ist in verschiedenen Formfaktoren verfügbar: von kompakten Embedded Systemen, die auf Jetson TX1 und TX2 basieren, über PC-GPUs wie den Grafikprozessor GTX 1080 bis hin zu speziellen KI-Plattformen wie DGX-1 und Drive PX 2 von Nvidia.

Deep Learning Frameworks: Neben der Entwicklung benutzerfreundlicher Frameworks trägt auch die breite Verfügbarkeit von Tutorien und Onlinekursen zur größeren Verbreitung von Deep Learning bei. Mithilfe von C++-Wrappen wie TensorFlow von Google und Open Source Software wie Caffe, Torch oder Theano geht das Erstellen und Trainieren eigener Deep Neural Networks schnell. Dank seiner Vielseitigkeit ist TensorFlow für die meisten Anwender am Anfang am besten. Durch die GPU-Optimierung von Caffe eignet sich dieses Framework perfekt für eine Kombination mit dem Jetson TX1 und TX2. Die Bibliothek Nvidia Cuda Deep Neural Network bietet Entwicklern Implementierungen häufig genutzter Deep Learning Funktionen.

Erfassung von Trainingsdaten

Nvidia-Hardware wie der TX1 (links), TX2 (Mitte) und Drive PX 2 (rechts) sind dank ihrer parallelen Rechnerarchitektur ideal, um Deep Learning Prozesse zu beschleunigen. (Bild: Flir Integrated Imaging Solutions, Inc.)

Die Entwickler müssen ein Deep-Learning-Modell trainieren, bevor sie es einsetzen können. Eine in die Kamera integrierte Bildverarbeitung vereinfacht die Datennormalisierung, die vor dem Training notwendig ist. Wenn genügend Trainingsdaten gesammelt sind, kann das Training beginnen, für dessen Beschleunigung auch PCs mit einer oder mehreren Cuda-fähigen GPUs oder spezielle KI-Trainingshardware wie Nvidia DGX-1 verwenden werden. Mittlerweile gibt es auch Cloud Computing Plattformen, die auf Deep Learning spezialisiert sind. Überdies ermöglichen GPU-beschleunigte Embedded Plattformen Anwendungen, deren Platz- oder Leistungsanforderungen durch herkömmliche PCs nicht erfüllt werden und eine begrenzte Internetverbindung oder eine extrem hohe Computing-Leistung notwendig machen. Diese Systeme basieren meist auf ARM-Prozessorarchitekturen und werden oft auf Linux-basierten Betriebssystemen ausgeführt. Nvidia Jetson TX1 und TX2 sind GPU-beschleunigte Plattformen, die USB 3.1 Gen1 und GigE Vision-Kameras unterstützen. Spezielle Jetson Trägerplatinen stellen die E/A-Verbindungen und anwendungsspezifische Funktionen bereit. SmartCow Tera+ unterstützt bis zu acht GigE-Kameras nativ über einen verwalteten Switch, und stellt auch einen Caffe Wrapper bereit, der die Entwicklung und Bereitstellung von Visionanwendungen auf Basis von Deep Learning auf der Tera+-Hardware vereinfacht. Auch der Connect Tech Cogswell Carrier unterstützt USB 3.1 Gen1 und GigE-Kameras mit PoE. Nvidia Drive PX 2 ist eine offene Automotive-KI-Plattform auf Grundlage von zwei Pascal-GPU-Kernen. Diese erreicht bis zu acht Tflops und hat damit die Rechenleistung von 150 Macbooks Pro. Neben Eingängen für USB 3.1 Gen 1- und GigE-Kameras verfügt sie über Anschlüsse für Kameras, die Automotive GMSL-Kameraschnittstellen verwenden.

Anwendungen

Auch wenn die Entwicklung selbstfahrender Autos viel Aufmerksamkeit auf sich zieht, gibt es noch eine ganze Reihe weiterer Anwendungen für Deep Learning. Diese sind z.B. die Interpretation von CT-Untersuchungen, die automatische Übersetzung von Texten bis hin zur Optimierung des städtischen Verkehrsablaufs. Deep Learning betriebene AOI-Software wie ViDi Red lernt von Segmenten, die als gut gelten und kann sowohl Defekte erkennen als auch akzeptable Variationen erkennen lernen. Das fortlaufende Training der Systeme erlaubt die Reaktion auf wechselnde Bedingungen. Das Unternehmen Here arbeitet z.B. an der Implementierung eines Kartensystems für autonome Fahrzeuge auf Basis von Deep Learning. Die Technologie soll fortlaufend aktualisierte Karten mit einer Auflösung von 10 bis 20cm erstellen. Damit erstellt Here Karten, die den genauen Standort von festen Objekten wie Signalen oder vorübergehende Behinderungen (Baustellen…) enthalten.