Die größte Herausforderung bei der Automatisierung der Holzverladevorgänge sind die sensorischen Unsicherheiten, die sich aus dem unförmigen Gutholzstämmen, den stark variierenden anliefernden LKWs, den schwankenden Licht- und Wetterverhältnisse unter freiem Himmel und ganz allgemein den noch wenig strukturierten und standardisierten Umgebung und manuellen Prozesse ergeben. Erst der Siegeszug von Deep Learning im Bereich Maschinelles Sehen macht heute eine robuste Lösung unter den beschriebenen Umgebungsbedingungen überhaupt möglich.

Systemarchitektur

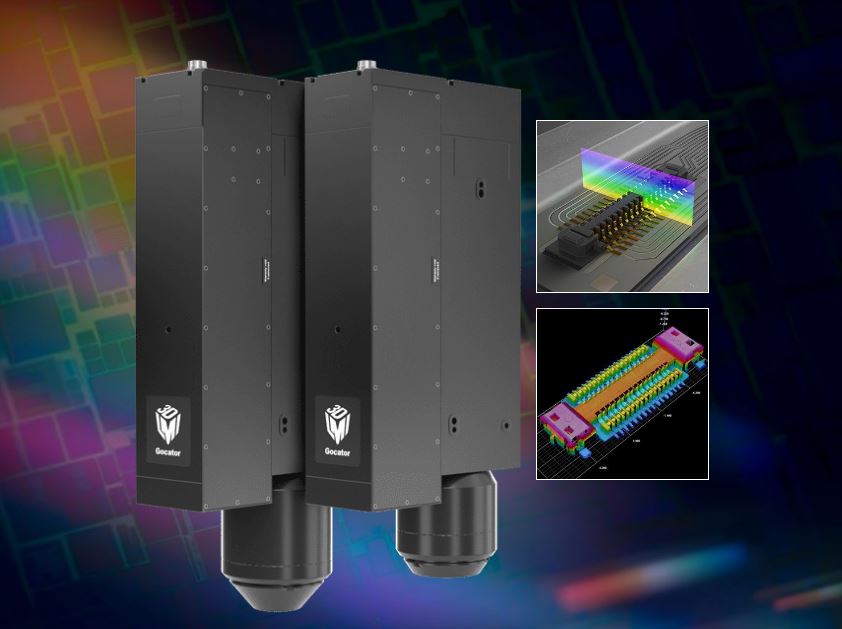

Die künstliche Intelligenz KAI ist in der proprietären Kognitiven Architektur PACT implementiert und wird auf einer Hard- und Softwareplattform ausgeliefert, die an bestehende Krane nachgerüstet und in neue Krane integriert werden kann. KAI kommuniziert über den Industriebus mit der Kransteuerung (PLC), erhält von dort Informationen und sendet an sie Befehle. Zusätzlich zu den vorhandenen Informationen über Gelenkpositionen und -bewegungen setzt KAI optische Sensoren ein, um den eigenen Greifer, Ladung und Umgebung zu erfassen. Die Sensoren sind über ein eigenes Gigabit-Netzwerk mit den Computern verbunden, die eine parallele Verarbeitung der eingehenden Daten (ca. 2GBit/s) in Echtzeit ermöglichen. Je bildgebendem Sensor wird ein dedizierter Computer (‚Sensor Node‘) eingesetzt, der die eingehenden Rohdaten verarbeitet und relevante Informationen extrahiert. Nur die Ergebnisse werden dann mit deutlich niedrigerer Bandbreite an die zentrale Recheneinheit (‚Core‘) gesendet und dort in einem kohärenten, prädiktiven Weltmodell integriert und kontinuierlich fortgeschrieben. Auf Basis dieser Information trifft KAI in einer geschlossenen Regelschleife mit 20Hz Handlungsentscheidungen und bricht diese bis auf konkrete Ansteuerungssignale (meist Zielgeschwindigkeiten) an alle Achsen des Krans herunter.

Perzeption

Jeweils im ersten Schritt der in den Sensor Nodes implementierten mehrschichtigen Bildverarbeitungsketten kommen künstliche Neuronale Netze zum Einsatz, die von den in Freiburg entwickelten U-Net und All-Conv-Net abgeleitet wurden. Im Falle des zentralen Sensors, einer an der Laufkatze montierten Industriekamera, ist dies das proprietäre ‚CraneNet‘ von Psiori. Dieses erkennt und segmentiert die Greiferaufhängung und den Greifer sowie am Prozess beteiligte Objekte (Ladung, Holzlager, LKW, Förderband) robust im Kamerabild. Durch den Einsatz eines Tiefen Neuronalen Netzes in der ersten Schicht der Bildverarbeitungskette und den Verzicht auf jegliche klassische Bildvorverarbeitung und Normalisierung zugunsten des Trainings und Deep Learnings wird eine Genauigkeit und Robustheit gegenüber Verdeckungen, Überlagerungen, Beleuchtungs- und Wetterschwankungen erreicht, die mit klassischen Bilderkennungsverfahren bisher so nicht möglich war.

Klassische, symbolische Verfahren des maschinellen Bildverstehens und der probabilistischen Robotik schließen sich an, um im Segmentierungsbild Objekte zu finden, zu verfolgen und geometrische Eigenschaften, wichtige Merkmale und Posen zu extrahieren. Hier kommen Verfahren wie Template-Matching, Partikel- und Kalmanfilter, Mutliple-Hypothesis-Tracking und Hypothesis Rejection zum Einsatz, die alle von der robusten Vorverarbeitung und Segmentierung durch das Neuronale Netz profitieren. Eine weitere Kamera am Fuß des Krans dient der Regelung der Greiferposition während des LKW-Entladevorgangs. Hier kommt das ‚TruckNet‘ in einer ähnlichen Verarbeitungskette zum Einsatz. Die berechneten Informationen beider Perspektiven werden an den Core gesendet, wo sie dank der kalibrierten Kameras fusioniert und ins Weltmodell integriert werden können.

Data Loop & Training

Zum Training der Neuronalen Netze werden Trainingsdaten – tausende Beispielbilder mit der gewünschten Netzausgabe – benötigt, die zunächst gesammelt, kuratiert und händisch annotiert werden müssen. Psiori realisiert dies mit der Cloud-Komponente CRID und dem semi-automatischen Datenmanagement in einem proprietären Data Loop-Prozess. Die an CRID übermittelten Sensordaten werden dabei in Beziehung zu wichtigen Maschinendaten (Kranzustand, Ansteuerungsbefehle, Fehlfunktionen) und den Logdateien von KAI gesetzt und vollautomatisch indiziert, so dass bestimmte Situationen auch in einer Sammlung von Millionen von Kamerabildern innerhalb von Sekunden händisch oder programmatisch gefunden werden können.

Fazit und Ausblick

Das System ist mit neuen Kranen der Andritz AG sowie als Nachrüstkit für bestehende Krane auch anderer Hersteller in Gänze oder in Modulen (z.B. Anti-Sway System, Kollisionsvermeidung, Zugriffsüberwachung) bereits erhältlich. Psiori arbeitet daran, die Teillösungen auch in anderen Branchen verfügbar zu machen und das Autonomielevel von der stetigen Überwachung durch einen Menschen hin zu höheren Leveln zu steigern.