Im Vergleich zu klassischen Bildverarbeitungsmethoden haben sich Deep-Learning-Algorithmen bei Segmentierungsaufgaben als besonders leistungsfähig erwiesen. Da es sich hierbei jedoch um eine so genannte dichte Vorhersage (Kennzeichnung jedes Pixels des Eingabebildes) handelt, ist die Segmentierung eine der ressourcenintensivsten Aufgaben in den Bereichen Computer Vision und Maschinellem Lernen. Dennoch sollte es gerade auch für Embedded-Anwendungen das Ziel sein, für derartige Aufgaben keine zusätzliche Hardware wie dedizierte Grafikkarten oder KI-Beschleuniger einsetzen zu müssen. Vielmehr gilt es, mit den neuen Prozessorgenerationen Aufwand, Platz und Kosten einzusparen und mit Hilfe der bereits zur Verfügung stehenden Ressourcen die KI-Aufgaben mit abzudecken.

Intel-Prozessoren mit Hybrid-Technologie

Welchen Fokus Intel bei der Definition der neuen CPU-Derivate auf dieses Anwendungsfeld legt, lässt sich bereits an den günstigen Einstiegsmodellen erkennen. Die neueste Generation der Intel-Atom-Prozessoren (Intel Atom x7000E Serie) beinhaltet die bereits aus der 12. Generation Intel-Core-Prozessoren bekannte und leistungsfähige Grafik-Controller-Architektur, die Inferenz-Aufgaben um ein Vielfaches schneller und effizienter bearbeitet als bei den Vorgänger-Generationen. Die neuen Intel-Core-Generationen stellen zudem viel mehr Rechenleistung zur Verfügung und beinhalten die Intel Hybrid-Technologie mit einer Kombination aus unterschiedlichen Typen von Prozessorkernen (E- und P-Cores). Parallel zu den eigentlichen Computing-Tasks können damit Bildvorverarbeitung und KI flexibel unterschiedliche Cores, GPU oder eine Kombination daraus nutzen. Über einen Software/Hardware-Abstraktions-Layer, der durch die Intel Distribution des OpenVino Toolkits bereitgestellt wird, ist die Realisierung mit ein und derselben Softwareimplementierung möglich. Damit ist sichergestellt, dass einerseits neue Applikationen bereits existierende Hardware bestmöglich nutzen und andererseits, neue Hardwarekonzepte flexibel gestaltet werden können. Da die KI-Aufgaben innerhalb des Prozessors laufen, ist eine gute Skalierung möglich: Bei Embedded-Modulen wie dem TQMx130 von TQ beispielsweise stehen zehn pin-kompatible CPU-Ausführungen zur Auswahl, die von fünf CPU-Kernen und 48 Grafik-Execution-Units bis hin zu vierzehn CPU-Kernen und 96 Grafik-Execution-Units reichen. Die klassischen Prozess-Tasks, die auf einem Standard-Prozessor laufen, können so um Bildvorverarbeitungsaufgaben und KI-Funktionen ergänzt werden, ohne auf externe Komponenten ausweichen zu müssen. Das vereinfacht den Design-Aufwand in Hard-/Software sowie mechanischer und thermischer Integration.

Lösche Person aus Video-Stream

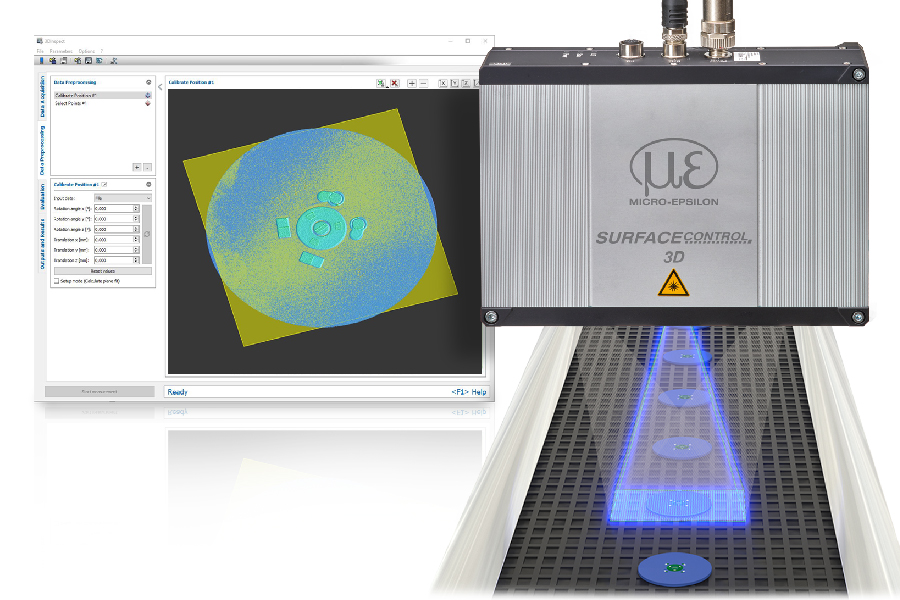

Wie leistungsfähig und dennoch ressourcensparend KI-basierende Bild-Segmentierung auf einem Intel-Core-i5-Prozessor läuft, zeigt das Beispiel ‚Lösche Personen aus einem Video-Stream‘. Die Demo führt mithilfe eines öffentlich verfügbaren vortrainierten DeepLabV3-Modells eine semantische Bildsegmentierung für einen 512×512-Eingabe-Stream durch. Aus den 21 verfügbaren Klassen im Modell wird dabei die Klasse Personen genutzt. In Bereichen die von Personen verdeckt werden, bleibt das Bild statisch, während das restlichen Bild weiter aktualisiert wird. So werden Personen aus dem Video-Stream effektiv entfernt.

um Embedded-Computing mit KI auch ohne Zusatzkomponenten optimal abzudecken. – Bild: TQ-Systems GmbH

4x schneller mit interner GPU

Die volle Leistungsfähigkeit und Energieeffizienz wird durch die Kombination aus integrierter Grafik und den CPU-Kernen erreicht. Für die Inferenz werden die parallel arbeitenden Execution-Units der integrierten Grafik genutzt, die in diesem Beispiel das Ergebnis in nur 25ms zur Verfügung stellen und somit mehr als um den Faktor vier schneller sind als die Verarbeitung über die klassischen CPU-Cores. Pre- und Post-Processing wie beispielsweise Delatation für das Glätten der Konturen zur Vermeidung von Artefakten werden über die CPU-Kerne abgedeckt, die dadurch jedoch nur gering ausgelastet werden. Kommen Aufgaben wie Encoding und Decoding von Video-Streams hinzu, werden diese effizient in den HW-Encodern/-Decodern ausgeführt, ohne dabei die CPU-Kerne selbst zu belasten. Die Betrachtung der Gesamtauslastung des Prozessors (CPU, GPU, interner Cache und externer Speicherbedarf) zeigt, dass bei Embedded-Modulen, die mit neuester Prozessortechnologie ausgestattet sind, die bisherigen Standard-Aufgaben des Moduls ohne weiteres um anspruchsvolle KI-Anwendungen ergänzt werden können und so auf den Einsatz kostspieliger und teils energiehungriger Zusatzkomponenten verzichtet werden kann.