Die Entwurfsmethodik

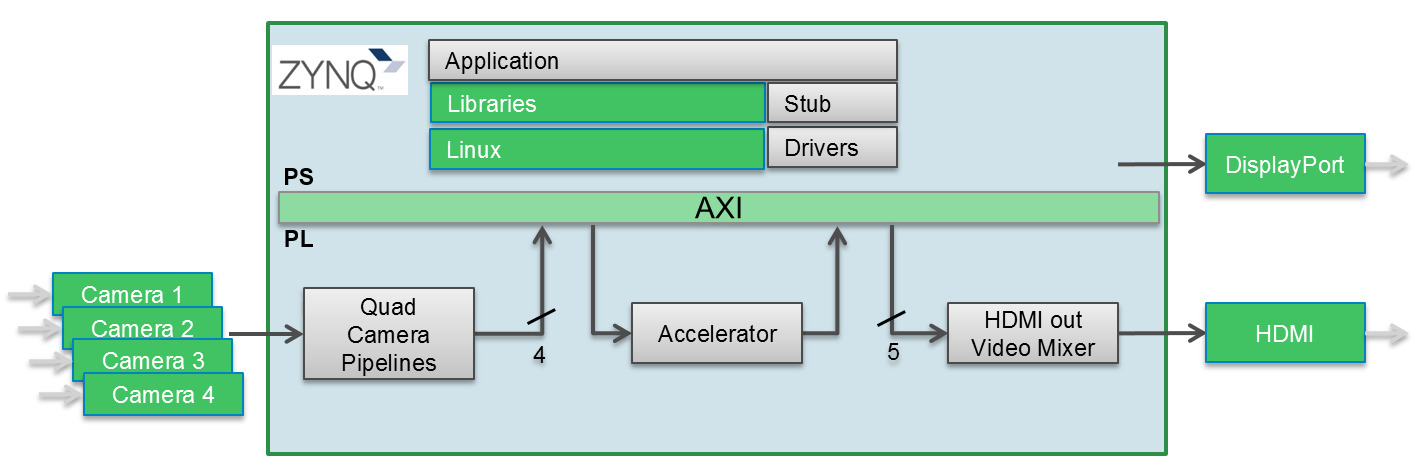

Die Entwurfsmethodik basiert auf, einer Reihe von Softwareressourcen zur Entwicklung von Algorithmen, Anwendungen und Plattformen. Sie arbeitet mit aktuellen Entwicklungstools für das Design von HW- und SW-Anwendungen, darunter die SDSoC-Umgebung von Xilinx, PetaLinux und Bibliotheken für Computer Vision und Machine Learning. Bild 2 zeigt ein vereinfachtes Diagramm der gesamten HW/SW-Architektur. Die Entwicklungs-Toolchain unterstützt auch GStreamer, ein Pipeline-basiertes Multimedia-Framework, mit dem Entwickler verschiedene Medienverarbeitungssysteme verknüpfen können, um komplexe Workflows abzuschließen. Das Pipeline-basierte Design wurde bisher für das Erstellen von Anwendungen wie Video-Editoren und Transcodern und der Verteilung von Media Streams verwendet, die auch eine Grundlage für das Erstellen einer auf Deep Learning basierenden Analyse von Streaming-Media-Daten bilden. Die Verwendung von Machine Learning bei Mehrkamerasystemen, inkl. Deep Learning mit mehreren internen Netzwerk-Ebenen, bedeutetet für Visionsysteme mit mehreren Kameras, dass effiziente Möglichkeiten gefunden werden müssen, um auf die Systemressourcen mit sehr hoher Rechenleistung zugreifen zu können. Die programmierbare Logikstruktur der Xilinx MPSoC bietet eine hohe dedizierte Rechenleistung – während die Toolchains, die das Unternehmen anbietet, sicherstellen, dass diese Ressourcen so effektiv wie möglich genutzt werden. Neuere Forschungen haben gezeigt, dass es für die Ausführung von neuronalen Netzen möglich ist, die Rechenlast- zu reduzieren, indem Matrix-Berechnungen, die nur eine sehr geringe Auswirkung auf das Ergebnis haben, aus der Netzwerkbeschreibung zu entfernen. Außerdem besteht die Möglichkeit, die Genauigkeit des verwendeten Zahlenraums zu verringern und 16- oder 8-Bit-Integer-Datentypen zu verwenden anstelle der komplexeren 32-Bit Fließkomma-Typen. Für bestimmte Teile der Netzwerke kann sogar mit noch geringeren Auflösungen bis hin zur Binärdarstellung gearbeitet werden. DeePhi Tech – ein Teil von Xilinx – bietet Tools zur Implementierung und Optimierung von Deep Learning an. Das DNNDK (Deep Neural Network Entwicklungskit) von DeePhi unterstützt die beliebtesten Entwicklungsplattformen für Deep Learning Netzwerke wie z.B. TensorFlow oder Caffe. Diese Toolkits ermöglichen es Entwicklern, mit verschiedenen Typen und Konfigurationen von Algorithmen für Deep Learning zu experimentieren. Ihre Ausgabe wird dann in die DNNDK-Toolchain übernommen, die ein Graph-Komprimierungstool (bekannt als Decent), einen Deep Neural Netzwerk-Compiler (DNNC) und Assembler (DNNAS) und eine Laufzeitumgebung für neuronale Netzwerke (N2Cube) umfasst. DeePhi hat auch Hardwarearchitekturen entwickelt, die für die Video- und Bilderkennung optimiert sind und mit Xilinx SOCs verwendet werden können. Simulatoren und Profiler sind in der DNNDK Toolchain ebenfalls enthalten. n