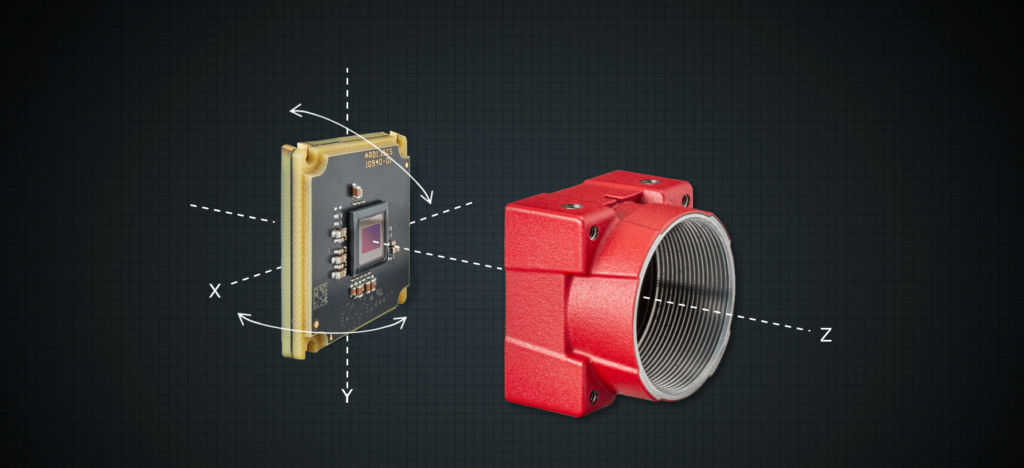

Moderne Kameralösungen für die digitale Bildverarbeitung bestehen aus einer Vielzahl unterschiedlicher Komponenten. Idealerweise haben diese Komponenten konstante Abmessungen und fügen sich nahtlos in hochpräzise Produkte ein. Von dem Sensor bis hin zur Linse wären alle Komponenten perfekt entlang der optischen Achse ausgerichtet. Doch in der Praxis weisen alle Teile Toleranzen auf, die mit dem bloßen Auge nicht erkennbar sind. Typische Sensoren dürfen zum Beispiel laut Spezifikation eine Neigung von 1° haben. Zusätzliche Toleranzen durch andere Komponenten wie das Sensorgehäuse selbst oder verursacht durch die Montage verschlechtern die Positionsgenauigkeit des Sensors, wenn Kameras ohne Sensorausrichtung hergestellt werden. Je nach Wahl des Objektivs fällt die Präzision der Ausrichtung ebenfalls unterschiedlich aus. Kostengünstige S-Mount-Objekte liefern beispielsweise eine geringere Genauigkeit oder Verlässlichkeit als hochwertige C-Mount-Optiken.

Negative Effekte

Je nachdem in welche Richtung die Ausrichtung entlang der optischen Achse abweicht, ergeben sich verschiedene Effekte, die die gewünschte Bildqualität beeinflussen (Bild 1):

– Neigung auf der Z-Achse: Das Bild hat eine Abweichung von 90m zwischen dem höchsten und dem niedrigsten horizontalen Pixel des Sensors, gemessen entlang der optischen Achse. Dies entspricht einer Drehung von 0,573° um die Y-Achse. Die daraus resultierende Fokusdrift verwischt die vertikalen Ränder.

– Drehung um die Z-Achse: Das Bild wird um 1° im Uhrzeigersinn gedreht. Die weiße senkrechte Linie kippt oben leicht nach rechts weg.

– Verschiebung entlang der X-Achse oder Y-Achse: Das Bild wird um 200m (~66 Pixel) nach oben verschoben. Der Schraubenkopf wird auf der oberen Seite abgeschnitten. Hinweis: Je nach Objektiv kann die Schärfe zwischen den Bildecken unterschiedlich sein. Eine mögliche Vignettierung wird ebenfalls aus der Mitte verschoben, was schwieriger zu korrigieren ist als eine typische Vignettierung, die in der Mitte liegt.

Jeder der drei Effekte tritt nicht alleine auf. Die Gesamtungenauigkeit der Sensorposition, die dadurch verursacht wird, ist erheblich. Die Effekte können zudem bei Sensoren mit höheren Auflösungen und kleineren Pixelgrößen zunehmen. Insbesondere bei Anwendungen, in denen ein Bildausschnitt am Rande des Sichtfeldes der Kamera die entscheidende Bildinformationen enthält, kommen die Auswirkungen zum Tragen. Unschärfe im Randbereich kann dazu führen, dass keine korrekte Analyse möglich ist und ein Bild fehlinterpretiert wird. Wird generiertes Bildmaterial für Deep Learning Prozesse verarbeitet, muss umso mehr Rechenkapazität verwendet werden, je unschärfer und ungleichmäßiger die generierten Bilder sind. Abhilfe schafft hier die optimale Ausrichtung sowohl des Sensors als auch des Objektivs durch die Active Alignment-Methode.